Keyan Ghazi-Zahedi hat im Interview auf cloud ahead seine Vision der Verwaltung der Zukunft geschildert. Die Idee: Deutschlands Verwaltung sollte anlassbezogen, antragsfrei, voll-automatisiert und service-orientiert funktionieren. Der Weg dorthin sei möglich, aber nicht auf dem herkömmlichen Weg der Digitalisierung einzelner Teilschritte entlang der heutigen Abläufe. Vielmehr müsse der Prozess mit dem Interesse der BürgerInnen ganzheitlich neu gedacht werden. Zudem sollten Behörden lernen, den bereits durchgeführten Prüfungen anderer Behörden zu vertrauen und diese wiederzuverwenden.

Die dritte Voraussetzung sei: Die künstliche Intelligenz müsste den digitalen Prozess in Form von Software erzeugen können. Dies könnte im Wesentlichen basierend auf Gesetzestexten, weiteren Verwaltungsvorgaben sowie kurzen Interviews weniger Know-how-Träger in der Verwaltung erfolgen.

In diesem Interview beschäftigen wir uns mit der Frage, ob die künstliche Intelligenz hierzu schon fähig ist, und wie eine Vorgehen dazu aussehen könnte.

Zur Person

Celsa Diaz-Tejada ist eine erfahrene Data-Science-Expertin mit einem Executive MPA in KI von der Hertie School Berlin und diversen Ausbildungen, unter anderem am MIT, der Universität Heidelberg und der Universität Madrid. Seit Oktober 2023 arbeitet sie als Senior Consultant bei PD auch an der Vision der Verwaltung der Zukunft.

Gregor: Celsa, wie seid ihr auf die disruptive Idee gekommen mit AI an der Verwaltung der Zukunft zu arbeiten?

Celsa: Keine unserer Ideen ist wirklich neu. Viele europäische Länder nutzen schon AI zur Automatisierung und Vereinfachung von Prozessen. Finnland etwa nutzt künstliche Intelligenz, um seinen BürgerInnen staatliche Leistungen vorzuschlagen. Die Idee der anlassbezogenen, antragsfreien, voll-automatisierten und service-orientierten Verwaltung hat ebenfalls europäische Vorbilder, etwa in Dänemark und Estland.

Disruptiv ist lediglich der Ansatz den Prozess neu und BürgerInnen-zentrisch zu denken. Wir in Deutschland versuchen zu häufig, basierend auf der heutigen IT, die bestehenden Prozesse in kleinen Schritten zu verbessern. Das erhöht dann in Summe die Komplexität und führt nicht unbedingt zu einem besseren Gesamtergebnis.

Wir möchten also den technologischen Fortschritt im Bereich der KI nutzen, um den Prozess der Digitalisierung selbst zu vereinfachen. Unsere Vision ist es, dass jede Fachkraft in einer Verwaltung, die weiß wie ein Prozess abläuft, diesen auch ohne ein Großprojekt digitalisieren kann.

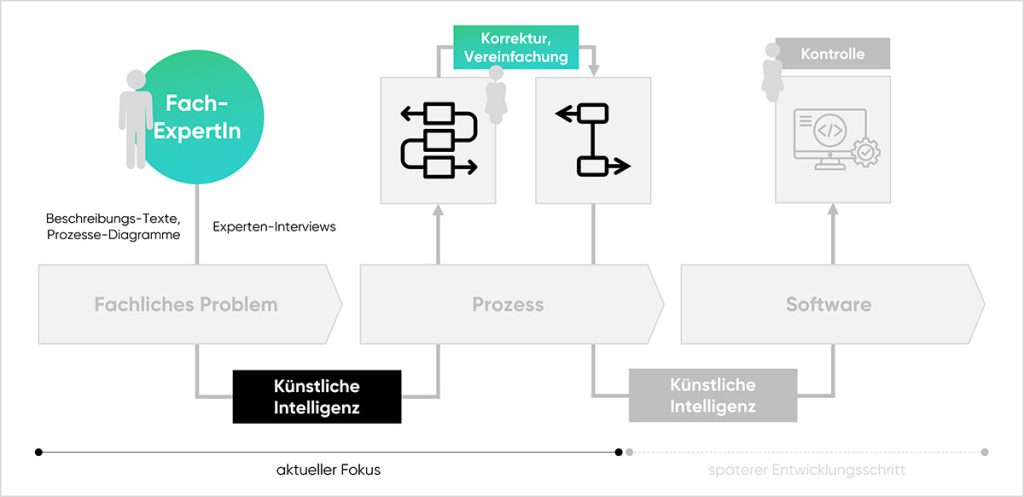

Aktuell setzen wir an zwei Teilschritten dieser Vision an: Der Extraktion des menschlichen Prozesswissens und der Beschreibung von Prozesses und Abhängigkeiten in einem Prozessdiagramm.

"Disruptiv ist lediglich der Ansatz den Prozess neu und BürgerInnen-zentrisch zu denken."

Gregor: An welcher Stelle wird denn die KI eingesetzt in eurer Vision? Bearbeitet sie wie ein Roboter jeden Vorgang des Bürgers?

Celsa: Nein, hierfür sind die Modelle nicht präzise genug. Wir nutzen KI, um aus nicht-technischen Daten wie Gesetzen, Anordnungen oder Videos und Ton-Aufnahmen von ExpertInnen Prozessbeschreibungen zu extrahieren. Diese dann werden von den Fachkräften in der Verwaltung geprüft und angepasst. In einem dritten Schritt erstellt die KI den passenden Software-Code. Dieser ist dann die vorhersehbare und überprüfbare Maschine, welche die Vorgänge in der Behörde zuverlässig bearbeitet.

Wir nutzen also die künstliche Intelligenz, um den Prozess der Digitalisierung zu digitalisieren. Die eigentliche Fachanwendung bleibt eine klassische, zuverlässige Software. Die Fachkraft der Verwaltung ist stets involviert und erhält die volle Kontrolle über die Automatisierung.

Gregor: Was macht dich so optimistisch, dass die heute verfügbaren KIs schon so weit sind?

Celsa: Ich beschäftige mich seit 7 Jahren mit Machine Learning und habe beobachtet, wie sich die Technologie entwickelt. Mit großen Sprachmodellen (LLMs) wie GPT-4 und Claude 3 sind wir zum ersten Mal auf einem Niveau, auf dem die KI mit einem einfache API-Call und ohne spezifisches Training bezogen auf ein Fachgebiet Prozessbeschreibungen zu genau diesem Fachgebiet generieren kann.

Vor dem Aufkommen der LLMs benötigte es große Teams mit Machine-Learning- und Domänen-ExpertInnen, um die Daten aufwendig aufzubereiten, die kleinen Modelle zu trainieren und diese zu fine-tunen. Zudem gab es meist zu wenig gute Daten, um eine hohe Output-Qualität zu erzeugen. Die kleinen Modelle waren darüber hinaus nur für sehr wenige, vordefinierte Anwendungsfälle nutzbar.

Die großen Modelle dagegen reduzieren die Komplexität der Nutzung deutlich. Sie sind einfach via API nutzbar und können multi-tasken, also Aufgaben bearbeiten, für die sie nicht spezifisch trainiert wurden. Hierzu reicht in der Regel das sogenannte „In-Kontext-Lernen“, also dem Modell genug spezifischen Kontext sowie ein Musterbeispiel für die Lösung mitzugeben.

"Wir nutzen die künstliche Intelligenz, um den Prozess der Digitalisierung zu digitalisieren.“

Gregor: Wie kann ich mir so ein Prompting der AI vorstellen? Kopiert der oder die Beamte dann einfach den Gesetzestext in ein Fenster und es kommt das Fachverfahren heraus?

Celsa: An einem einfach verständlichen User Interface arbeiten wir in der Tat.

Im Zentrum davon steht die Upload-Funktion für Dokumente. Hier lädt die Fachkraft aus der Verwaltung die vorhandenen Prozessbeschreibungen, Diagramme und andere Texte hoch. Aber es gibt auch die Möglichkeit, Videos und Tonaufzeichnungen hochzuladen, später könnten auch Anweisungen direkt eingesprochen werden.

Dann prüfen wir: Sind in diesen Daten aussagekräftige Prozessinformationen vorhanden? Wenn nicht, bekommen die NutzerInnen entsprechendes Feedback. Sind genug relevante Details von der KI extrahierbar, erstellen wir erst einen XML-Code, den wir dann über vorhandene Tools in ein Prozessdiagramm nach BPMN umwandeln können. Im nächsten Schritt dann können die NutzerInnen das Diagramm anpassen und nach Belieben erweitern.

Mittelfristig könnte daraus dann der Code für die Fachanwendung entstehen. An diesem Punkt wird es noch einmal auf andere Weise komplex. Moderne Software besteht ja nicht nur aus der fachlichen Logik, sondern beinhaltet auch Funktionen rund um Authentifizierung, Sicherheit, Compliance, Steuerung von Infrastruktur, Schnittstellen und vieles mehr.

Gregor: Für welches Sprachmodell habt ihr euch entschieden? Und wie sieht die Gesamt-Architektur der Anwendung aus?

Celsa: Wir möchten, dass Verwaltungen jeglicher Art schneller und besser digitalisieren. Daher arbeiten wir an einer Architektur, die Modell- und Infrastruktur-neutral ist.

Begonnen haben wir unsere Experimente mit GPT4 (von OpenAI) und Claude 3 Opus (von Anthropic). Langfristig ist es jedoch unser Ziel, auf Open-Source-LLMs zu setzen. Konkret erwägen wir in einer zweiten Phase Tests mit Mixtral-8x7B-Instruct-v0.1 (Mistral Ai) durchzuführen, das sehr gut mit deutscher Sprache arbeitet. Der Plan ist einen PoC mit der Anwendung vor Ort für unsere Kunden bereitzustellen, die in einem Docker-Container gehostet wird. Somit kann unsere Lösung in allen modernen Public- und Private-Clouds genutzt werden.“

Bayern könnte in diesem Ansatz also sein Bayern-LLM verwenden und als Infrastruktur die Grafikkarte von Markus Söder nutzen – wenn diese leistungsfähig genug ist und er dort einen Kubernetes-Cluster betreibt.

Dank dieses mehrfach agnostischen Ansatzes können wir drei Compliance-Grade ermöglichen. In der privatesten Variante kann sich der Kunde für ein eigenes Modell auf der eigenen Infrastruktur entscheiden. Für die nächste Stufe ist die Nutzung der Public Cloud denkbar mit Open-Source-Modellen oder LLMs, die ihre Daten nicht anderweitig nutzen. Für ohnehin öffentliche Daten wiederum könnten sogar kostenlose closed-source LLMs eingebunden werden.

"Die Breite und Tiefe, mit denen sich die deutsche Verwaltung beschäftigt, ist praktisch unendlich."

Gregor: Welche technischen Herausforderungen erwartest du in der kommenden Proof-Of-Concept-Phase?

Celsa: Die Hauptherausforderung liegt darin die Qualität der erzeugten Prozessbeschreibung sicherzustellen. Die Breite und Tiefe, mit denen sich die deutsche Verwaltung beschäftigt, ist praktisch unendlich. Uns muss es also gelingen, gute Prozessdiagramme für viele unterschiedliche Fachdomänen zu erstellen.

Prof. Dr. Henrik Leopold hat uns freundlicherweise erste Testdaten zur Verfügung gestellt. Die ersten Versuche hiermit deuten darauf hin, dass wir auf dem richtigen Weg sind. Allerdings: Wir benötigen viel mehr Anwendungsfälle, an denen wir trainieren können.

Gregor: Was sind jetzt eure nächsten Schritte?

Celsa: Im Moment arbeiten wir an der Automatisierung der Pipeline zur Extraktion des Textes aus verschiedenen Dokumententypen, wie pdfs, Audio und dessen Umwandlung in aussagekräftige BPMN-Diagramme. Darüber hinaus richten wir eine Auswertungspipeline ein, um die Optimierung der Prompts (Prompt-Engineer-Methode) zu automatisieren, die GPT-4 zur erfolgreichen Erfüllung unserer Aufgabe nutzt.

Parallel entwerfen wir ein einfaches User Interface, denn alles was wir tun soll von möglichst vielen Menschen in der Verwaltung nutzbar sein.

Aus technologischer Sicht wird es danach vor allem darum gehen, möglichst viele Daten und Use Cases einzusammeln, um die Funktionsfähigkeit unserer Anwendung auf möglichst viele Bereiche zu erweitern.

Gregor: Klingt super-spannend. Gibt es eine Möglichkeit für unsere LeserInnen mitzuwirken?

Celsa: Ja, auf jeden Fall. Zum einen werden wir in den nächsten Monaten ein technisches Whitepaper erstellen. Wir möchten unser Konzept einem möglichst breiten, fachlichen Feedback unterziehen. Zudem benötigen wir mehr Anwendungsfälle und Testdaten.

Wir freuen uns also über alle MitmacherInnen – egal ob mit technischem Hintergrund oder aus dem Bereich der Anwendung. Für Interessierte haben wir eine Landing Page erstellt, bei der man sich melden kann: https://www.cloudahead.de/verwaltung-der-zukunft.

Gregor: Vielen Dank für Deine Zeit.