Dieses Interview ist Teil einer 7-teiligen Zusammenarbeit von cloud ahead und dem KI-Park e.V. zum Thema 'Souveräne KI-Infrastruktur'.

Jonathan Atkin ist Managing Partner von RBC Capital Markets und hat sich spezialisiert auf Forschung und Analyse zu Investitionen in Kommunikationsinfrastruktur.

Gregor: Was ist nötig, damit Deutschland als Standort für Investitionen in KI-Infrastrukturen attraktiv wird?

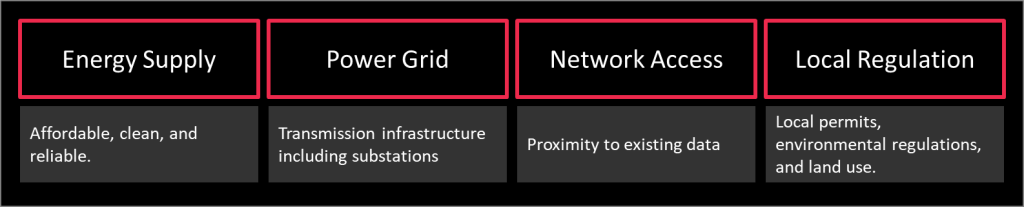

Jonathan: Um KI-Infrastruktur zu unterstützen, benötigen wir eine Energieversorgung, die sowohl günstig als auch sauber ist. Darüber hinaus brauchen wir ein robustes Stromnetz. Mit „Netz“ meine ich die Infrastruktur, die benötigt wird, um Strom effizient zu übertragen. Für KI-Anwendungen mit niedriger Latenz ist zudem ein zuverlässiger Netzzugang entscheidend, wobei die spezifischen Anforderungen von der Art der KI abhängen. Beispielsweise benötigt das Training von Modellen nicht viel Netzkapazität, da Latenz hier keine kritische Rolle spielt. Beim Inferenzprozess hingegen, bei dem es auf Bruchteile von Sekunden ankommt, wird die Nähe zu Netzknotenpunkten deutlich wichtiger.

Während alle KI-Anwendungen Energie benötigen, verschiebt sich der Fokus von „grüner“ Energie leicht. Große Internetunternehmen verfolgen weiterhin grüne Energieziele, aber mit dem Aufstieg der KI überwiegt oft der reine Energiebedarf die grüne Komponente. So werden Energiequellen wie Erdgas, das zwar nicht zu 100 % grün, aber sauberer als viele Alternativen ist, relevanter. Noch vor zwei oder drei Jahren galt Erdgas als rückläufige Energiequelle für Rechenzentren, doch aufgrund der steigenden Nachfrage nach zuverlässiger Energie nimmt seine Bedeutung wieder zu.

Gregor: Wird KI auch die Debatte um Kernkraftwerke verändern?

Jonathan: Tatsächlich erlebt die Kernenergie derzeit eine Art Comeback. Sie ist emissionsfrei, steht aber weiterhin in der Kritik wegen Sicherheits- und Entsorgungsfragen. Sowohl großflächige Kernkraftwerke als auch kleine modulare Reaktoren (SMRs) stoßen auf wachsendes Interesse. Unternehmen wie Microsoft, Amazon und Oracle haben öffentliche Statements gemacht – und sind in einigen Fällen Verpflichtungen eingegangen – die Kernenergie zu unterstützen. Kernenergie wird aktiv als praktikable Option zur Deckung des wachsenden Energiebedarfs diskutiert, obwohl sie umstritten bleibt.

Ein großes Hindernis für die Kernenergie sind NIMBY-Einwände („Not In My Backyard“). Während Befürworter argumentieren, dass moderne Technologien die Risiken früherer Vorfälle wie in den 1970er Jahren oder in Fukushima 2012 gemindert haben, bleibt der Widerstand in Wohngebieten bestehen. Die zentrale Frage ist, wo neue Kernenergieprojekte angesiedelt werden könnten, um Widerstände zu minimieren und die Machbarkeit zu maximieren.

„Kernkraftwerke stoßen bei den örtlichen Gemeinden auf Ablehnung - NIMBY: Not-in-my-backyard.“

In den USA hat beispielsweise Amazon zugesagt, 300 Megawatt Kernenergie aus einem bestehenden Kraftwerk in Pennsylvania zu beziehen, was möglicherweise auf ein Gigawatt ausgebaut wird. Microsoft hat sich verpflichtet, ein stillgelegtes Kernkraftwerk in Three Mile Island, ebenfalls in Pennsylvania, wiederzubeleben, um seinen Energiebedarf zu decken. Solche Projekte zeigen das Potenzial, bestehende Kernenergieinfrastruktur zu nutzen, um Engpässe zu lösen.

Gregor: Meiner Beobachtung nach dauert es jedoch +15 Jahre, bis ein Kernkraftwerk Strom liefert, und die Kosten liegen bei über 30 Milliarden Euro.

Jonathan: Der Bau neuer Kernkraftwerke ist tatsächlich teuer und zeitaufwendig. Kleine modulare Reaktoren (SMRs) könnten jedoch eine kompaktere und dezentralere Option bieten. Sie lassen sich schneller und mit weniger Ressourcen realisieren, sind aber nicht frei von Herausforderungen, vor allem, was die Akzeptanz in der Bevölkerung angeht.

Für Hyperscaler und andere große Energieverbraucher wird Kernenergie zunehmend Teil der Diskussion über nachhaltige Energie. Angesichts des wachsenden Bedarfs an KI und anderen rechenintensiven Arbeitslasten könnte die Kernenergie eine Schlüsselrolle spielen, um eine stabile und skalierbare Energieversorgung sicherzustellen. Die Zukunft solcher Projekte hängt jedoch davon ab, ob es gelingt, den öffentlichen Widerstand zu überwinden, Finanzierung zu sichern und regulatorische Hürden zu meistern.

Gregor: Diese Debatte ist ja wirklich alt. Hast du schon einmal einen kleinen Kernreaktor in Aktion gesehen?

Jonathan: Ein häufiger Vergleich ist der mit Atom-U-Booten, die noch kleinere Reaktoren nutzen und seit Jahrzehnten ohne größere Zwischenfälle im Einsatz sind. Daraus ergibt sich die Überlegung, dass man eher von der Technologie der U-Boote nach oben skaliert, anstatt große Kernkraftwerke herunterzuskalieren. Doch obwohl die Technik sicher ist, bleibt die Herausforderung, diese kleinen Reaktoren in der Nähe von Wohngebieten zu platzieren. Auch kleine Atomkraftwerke haben mit NIMBY-Protesten („Not In My Backyard“) zu kämpfen.

Wie du bereits angemerkt hast, sind auch die Kosten schwer abzuschätzen, da diese Art von Reaktoren noch nicht in großem Maßstab umgesetzt wurde. Ohne eine breite Einführung ist es schwierig, ihre Wirtschaftlichkeit zu bewerten. Experten argumentieren außerdem, dass die Vielfalt der nuklearen Technologien die Entscheidungsfindung verkompliziert. Wenn der Markt das alleine regeln soll, könnte es sehr lange dauern, bis sich eine Standardlösung etabliert. Ein standardisierter Ansatz – wie ihn Frankreich in der Vergangenheit verfolgt hat – könnte die Entwicklung beschleunigen und Kosten senken. Dafür wären allerdings tiefgreifende Änderungen in der Industriepolitik und eine stärkere regulatorische Abstimmung nötig.

Gregor: Dein U-Boot-Vergleich ist interessant, aber ich bezweifle, dass wir bald neue Kernkraftwerke in größerem Umfang sehen werden. Lass uns zurück zur KI-Infrastruktur kommen: Gibt es weitere wichtige Faktoren?

Jonathan: Regulierung spielt eine entscheidende Rolle. Mit dem wachsenden Bedarf an Cloud-Lösungen sind lokale Genehmigungen und Flächennutzungsbewilligungen immer wichtiger geworden. Selbst wenn geeignete Flächen verfügbar sind, können sie durch industrielle oder landwirtschaftliche Nutzung eingeschränkt sein, was zusätzliche Genehmigungen erfordert. Jede Kommune hat eigene Vorgaben, und nationale Regelungen fügen eine weitere Komplexitätsebene hinzu.

Rechenzentren stehen dabei unter besonderer Beobachtung, da sie wesentlich energieintensiver sind als Einkaufszentren oder Bürogebäude. Ihr hoher Energiebedarf belastet das Stromnetz stark, was sie zu einer Sonderkategorie macht. Früher war die Beschaffung von Land und Energie oft ein gemeinsamer Prozess; mittlerweile werden diese Aspekte jedoch getrennt betrachtet. Umweltauflagen erschweren die Lage zusätzlich: Wenn ein Rechenzentrum in der Nähe eines Flusses gebaut wird, müssen potenzielle Auswirkungen auf die Wasserqualität, Lärmbelastung und die Tierwelt berücksichtigt werden – etwa Zugvögel in Regionen wie Kalifornien.

Auch der Wasserverbrauch für die Kühlung von Rechenzentren ist ein Umweltthema. Neben diesen physischen und ökologischen Herausforderungen ist der Mangel an Fachkräften ein weiterer kritischer Faktor. Der Bau und die Ausstattung von Rechenzentren erfordern hochqualifizierte Elektrotechniker, die auch in anderen Branchen wie der Halbleiterfertigung stark nachgefragt werden. Dieser Wettbewerb um Fachkräfte stellt die Branche vor zusätzliche Schwierigkeiten.

Gregor: Apropos Fachkräfte: Wie viele Arbeitsplätze schaffen große Rechenzentren eigentlich lokal?

Jonathan: Während der Bauphase entstehen Hunderte von Arbeitsplätzen, was die lokale Wirtschaft vorübergehend ankurbelt. Sobald das Rechenzentrum in Betrieb ist, werden jedoch meist nur etwa 30 Vollzeitmitarbeiter benötigt, um den Betrieb rund um die Uhr aufrechtzuerhalten. Das bedeutet, dass Rechenzentren zwar während der Bauzeit viel Aktivität und Investitionen erzeugen, der Arbeitskräftebedarf jedoch nach der Fertigstellung stark abnimmt und die Arbeiter oft zum nächsten Projekt weiterziehen. Sie tragen langfristig eher durch Steuereinnahmen zur lokalen Wirtschaft bei als durch die Schaffung dauerhafter Arbeitsplätze.

Gregor: Können Rechenzentren trotzdem als Ankerinvestitionen für die lokale Wirtschaft dienen?

Jonathan: Irland ist ein gutes Beispiel dafür, wie Steueranreize große Investitionen anziehen und das lokale BIP und den Wohlstand erheblich steigern können. Microsoft und Facebook (heute Meta) haben bei ihrer Expansion nach Europa Dublin gewählt, unter anderem wegen der Steuervergünstigungen, die die Irish Development Authority (IDA) angeboten hat.

Auch in den USA gibt es Regionen ohne oder mit sehr niedrigen Umsatzsteuern, was Unternehmen ebenfalls anzieht. Neben den Energiekosten spielt die steuerliche Belastung eine entscheidende Rolle bei der Wahl des Standorts für KI-Rechenzentren. Server, die alle 3–5 Jahre ausgetauscht werden müssen, sind eine erhebliche Kostenquelle, und die Besteuerung hängt vom Standort ab. Regionen mit niedrigen Steuern bieten hier einen deutlichen Vorteil im Vergleich zu Standorten mit hohen Sätzen. Dies wird in die Gesamtkosten eines Rechenzentrums über dessen Lebensdauer von 15–25 Jahren einkalkuliert.

In Europa spielen regionale Steuerunterschiede ebenfalls eine wichtige Rolle. Während die Steuersätze in Deutschland landesweit relativ einheitlich sind, gibt es in anderen europäischen Ländern größere Unterschiede. Irland hat dies früh erkannt und durch die Schaffung eines attraktiven Steuerumfelds einen Vorsprung bei der Ansiedlung von Cloud-Computing- und Social-Networking-Unternehmen erreicht.

Gregor: Wird Frankfurt Deutschlands IT-Hauptstadt bleiben?

Jonathan: Einschränkungen bei Stromnetzkapazitäten und Energieversorgung in Frankfurt zwingen Unternehmen dazu, nach Alternativen in sogenannten Tier-2-Standorten zu suchen. Diese Unternehmen prüfen Standorte mit ausreichender Verfügbarkeit von Land und Energie, sind aber oft nur bereit zu investieren, wenn eine klare Kundennachfrage besteht. Berlin wird häufig als möglicher zweiter IT-Hub genannt, und das Interesse großer Internetunternehmen an der Stadt wächst. Allerdings hat sich in Städten wie Hamburg oder München bisher keine nennenswerte Nachfrage entwickelt, weshalb sie voraussichtlich auch in Zukunft eher Nebenstandorte bleiben.

Diese Dynamik lässt sich durch das Prinzip der Daten-Gravitation erklären: Bestehende Rechenzentren, wie in Frankfurt, beherbergen bereits große Mengen an Unternehmensdaten. Um rechenintensive Aufgaben oder KI-Arbeitslasten effizient durchführen zu können, muss die Infrastruktur in der Nähe der Daten sein. Dadurch zieht Frankfurt weiterhin Investitionen an, und seine zentrale Rolle wird trotz Einschränkungen bei Strom und Flächen wohl nicht so schnell abnehmen.

„Rechenzentrums-Cluster aggregieren oft dort, wo sich die Daten befinden - das ist die Datengravitation.’’

Zum Beispiel ist Mainova, das Unternehmen, das für den Bau einer neuen Umspannstation zur Unterstützung des Frankfurter Strombedarfs zuständig ist, voraussichtlich erst 2030 oder sogar 2032 mit der Arbeit fertig. Trotz dieser Verzögerungen haben Unternehmen kaum Alternativen und müssen entweder abwarten oder kreative Lösungen finden, um kleine Kapazitätslücken zu nutzen. Gebiete östlich von Frankfurt, wie Hanau und Offenbach, sind bereits zu sekundären Aktivitätszonen geworden, stoßen jedoch ebenfalls an ihre Grenzen. Weiter östlich könnte Dietzenbach Potenzial bieten, da die Netzengpässe dort offenbar weniger gravierend sind.

Sobald Mainova seine Infrastrukturmaßnahmen westlich von Frankfurt abgeschlossen hat, wird eine Welle neuer Bauprojekte und Kapazitätsnutzung erwartet. Auch wenn dies angesichts der aktuellen Engpässe widersprüchlich erscheint, bleibt Frankfurt aufgrund des Cluster-Effekts von Rechenzentren ein zentraler Standort. Ähnlich wie ein Einkaufszentrum, das durch eine Vielzahl von Geschäften Besucher anzieht, bevorzugen Unternehmen Standorte mit einer Vielzahl von Cloud-Anbietern. Dies reduziert betriebliche Risiken und gewährleistet Zugang zu verschiedenen Serviceoptionen.

Gregor: Bedeutet das, dass keine andere Stadt in Deutschland jemals eine Chance hat, mit Frankfurt zu konkurrieren?

Jonathan: Aktuell hat keine andere deutsche Stadt die kritische Masse erreicht, die erforderlich wäre, um Frankfurt ernsthaft Konkurrenz zu machen. Es gibt jedoch Potenzial in Nordrhein-Westfalen (NRW). Microsoft hat zum Beispiel Genehmigungen für den Bau eines großen Standorts in der Region erhalten. NRW profitiert von seiner historischen Industrieinfrastruktur, einschließlich Zugang zu Braunkohle und etablierten Netzwerken. Dies könnte NRW zu einem zweiten Daten-Schwerpunkt in Deutschland machen, obwohl der Bau noch nicht begonnen hat.

Auch Berlin bleibt im Gespräch. Obwohl die Stadt noch nicht zu einem bedeutenden IT-Hub geworden ist, wird ihr Potenzial von großen Unternehmen untersucht. Für Microsoft und andere besteht die Strategie darin, in der Nähe bestehender Cloud-Cluster zu bauen, um flexibel zwischen KI-spezifischen Workloads und anderen Cloud-Diensten wechseln zu können, falls sich die Nachfrage ändert.

Gregor: Was genau bedeutet Daten-Gravitation, und wie mächtig ist sie wirklich?

Jonathan: Die Idee, Daten nahtlos rund um die Welt zu bewegen, klingt einfach, ist aber in der Realität wesentlich komplizierter und teurer, als viele denken. Zum Beispiel: Ein mittelgroßes Rechenzentrum mit etwa 1,2 Petabyte an Daten – das klingt nach etwas, das sich mit moderner Glasfasertechnologie schnell übertragen ließe. Doch selbst mit fortschrittlicher Technik von Unternehmen wie Ciena oder Cisco könnte es Monate dauern, diese Daten über eine Distanz von nur 300 Kilometern zu bewegen.

Natürlich könnte man die Geschwindigkeit und Kapazität dieser Netzwerke technisch verbessern, aber die Kosten wären enorm hoch.

„Überraschenderweise ist der schnellste Weg, große Datenmengen zu transportieren, immer noch der LKW, nicht die Glasfaser.’’

Überraschenderweise ist der schnellste Weg, große Datenmengen zu bewegen, nicht über Glasfasernetze, sondern über den physischen Transport per Lkw. Unternehmen wie Amazon haben dafür sogar spezielle Lösungen entwickelt, beispielsweise ein Produkt namens „Snowmobile“. Dabei werden die Daten auf Speichergeräte heruntergeladen, per Lkw zum Zielort transportiert und dort wieder hochgeladen. Erstaunlicherweise ist diese Methode immer noch schneller als die Nutzung selbst der fortschrittlichsten Glasfasernetze, die heute verfügbar sind.

Gregor: Vielen Dank für deine Zeit, Jonathan!